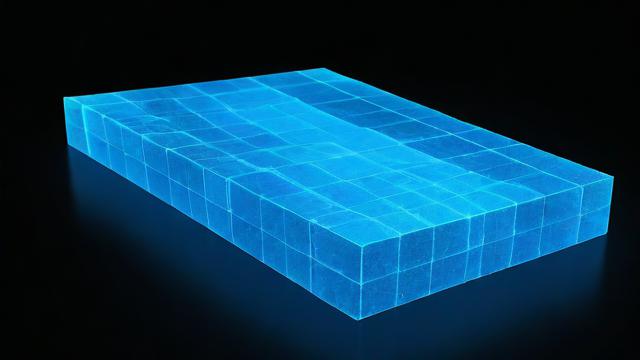

卷积核(Convolution Kernel),也称为滤波器或特征检测器,是卷积神经网络中的核心组件之一,它主要用于在输入数据上执行卷积操作,从而提取特征并生成输出,卷积核可以看作是一个小型矩阵,通过与输入数据的局部区域进行元素乘积和求和,实现对特征的捕捉和转换。

卷积核的大小通常为奇数×奇数,例如3×3、5×5等,每个卷积核都包含一定数量的参数(即权重和偏置),这些参数在训练过程中通过反向传播算法进行更新,以最小化损失函数,卷积核在卷积神经网络中的作用类似于人眼的视网膜细胞,它们能够检测到图像中的不同特征,如边缘、角点等。

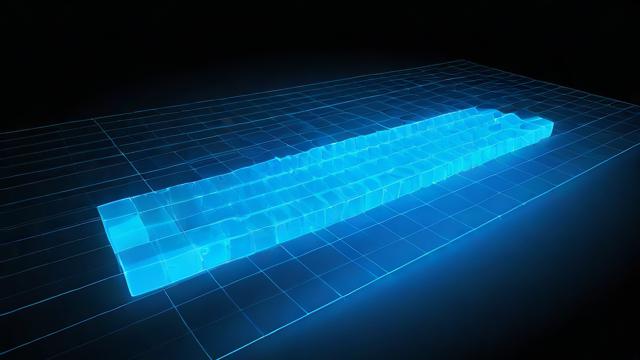

在卷积操作中,卷积核会在输入数据上滑动,并在每个位置计算加权和,从而生成一个新的特征图(Feature Map),这个过程可以表示为:

[ \text{输出}(i, j) = \sum_{m}\sum_{n} \text{输入}(i+m-1, j+n-1) \cdot \text{卷积核}(m, n) + \text{偏置} ]

(i, j)表示输出特征图上的像素位置,(m, n)表示卷积核上的权重位置。

卷积核的主要特点包括:

1、局部连接性:卷积核只与输入数据的局部区域相连,这使得模型能够捕捉到局部特征,同时减少了参数的数量。

2、权重共享:在整个输入数据上,卷积核的权重是共享的,这意味着无论卷积核在输入数据的哪个位置,其权重都是相同的,这进一步减少了模型的参数数量,并提高了计算效率。

3、多通道处理:卷积核可以处理多通道输入数据,例如彩色图像的RGB三个通道,通过将卷积核应用于每个通道,并将结果相加,可以得到最终的输出。

4、特征层次性:通过堆叠多个卷积层,模型可以逐层提取更高级的特征,第一层卷积可能提取边缘特征,而后续层则可能提取更复杂的形状或纹理特征。

卷积核的类型多种多样,根据其功能和应用的不同,可以分为以下几类:

1、标准卷积核:用于提取图像的基本特征,如边缘、角点等。

2、池化卷积核:用于降低特征图的空间维度,同时保留重要特征,常见的池化操作包括最大池化和平均池化。

3、转置卷积核:用于将低分辨率特征图恢复到高分辨率,常用于图像生成和超分辨率任务。

4、深度可分离卷积核:将标准卷积核分解为深度卷积和逐点卷积两部分,以减少计算量和参数数量。

5、膨胀卷积核:通过在卷积核之间插入零填充,扩大感受野而不增加参数数量,适用于图像分割等任务。

卷积核的设计和选择对于卷积神经网络的性能至关重要,合理的卷积核大小、数量和类型可以帮助模型更好地捕捉输入数据的特征,从而提高分类、检测或分割等任务的准确性,卷积核的优化也是卷积神经网络研究的一个重要方向,包括如何设计更有效的卷积核结构、如何初始化卷积核参数以及如何调整卷积核的学习率等。

卷积核是卷积神经网络中不可或缺的组成部分,它们通过局部连接、权重共享和多通道处理等特点,实现了对输入数据特征的有效提取和转换,随着深度学习技术的不断发展,卷积核的设计和应用也将不断演进和创新。

FAQs:

Q1: 卷积核的大小如何影响卷积神经网络的性能?

A1: 卷积核的大小直接影响卷积神经网络的感受野和计算复杂度,较大的卷积核可以覆盖更大的输入区域,从而捕捉到更多的上下文信息,但同时也会增加计算量和参数数量,较小的卷积核则相反,它们可以减少计算负担,但可能无法充分捕捉到长距离依赖关系,在选择卷积核大小时,需要权衡感受野和计算效率之间的关系,并根据具体任务和数据集进行调整。

Q2: 为什么卷积核要使用权重共享?

A2: 权重共享是卷积神经网络的一个重要特性,它允许同一个卷积核在整个输入数据上重复使用相同的权重参数,这样做的好处主要有两点:一是减少了模型的参数数量,从而降低了过拟合的风险;二是提高了计算效率,因为相同的计算可以在多个位置重复使用,而无需重新计算权重,权重共享还有助于模型学习到更加通用的特征表示,因为这些特征在不同的位置和不同的输入样本上都是有效的。

各位小伙伴们,我刚刚为大家分享了有关“卷积核”的知识,希望对你们有所帮助。如果您还有其他相关问题需要解决,欢迎随时提出哦!